模型在线部署

什么是模型在线部署

模型在线部署,指将训练好的单个机器学习模型或模型Pipline保存至HDFS,并以Restful API形式对外提供模型服务。通过API传入入参,系统进行模型运行,将运行结果返回给调用方,实现模型的在线预测。

可视化实验模型部署方式

AIWorks支持2种模型部署方式:SingleModel部署、Pipline部署。

-

SingleModel部署:仅部署可视化实验中的单个机器学习模型,适用于单个模型的预测,输入为模型特征列;

-

Pipline部署:支持部署可视化实验中的模型流程(数据源+特征工程+机器学习),适用于整个建模流程预测,输入原始数据即可。

SingleModel部署

实验运行成功,产生模型文件后,模型处于可部署状态,可开始模型部署:

步骤一 :在实验编辑页面操作栏点击模型在线部署按钮,选择SingleModel部署方式。

步骤二:选择部署模型、部署类型,定义模型名称与描述。

-

选择部署模型:可选的模型为当前实验流程中运行成功的机器学习模型;

-

部署类型:包含新建模型服务与增加已有模型服务版本。

-

新建模型服务:即新增模型,需定义模型名称与模型描述。

-

模型名称:不超过32个字符,支持字母、数字与下划线;

-

模型描述:不超过200个字符,除空格外,不限制其他字符格式;

-

-

增加已有模型服务版本:选择已部署的某个模型,在该模型上增加一个版本号,同个模型的调用地址一样,可选择哪个版本对外提供服务。

-

选择已有模型:选择单个已部署模型;

-

模型版本号:系统自增,标识该模型;

-

-

| AIWorks现支持的机器学习模型中,时间序列不支持模型在线部署。 |

步骤三:模型部署成功后,系统将提该模型的RestfulAPI,并可进入在模型管理页面进行模型调试,开始模型调用。

Pipline部署

实验运行成功后,可开始Pipline部署,Pipline可部署实验流程中数据源-特征工程-机器学习整个流程。

步骤一:在实验编辑页面操作栏点击模型在线部署按钮,选择Pipline部署方式。

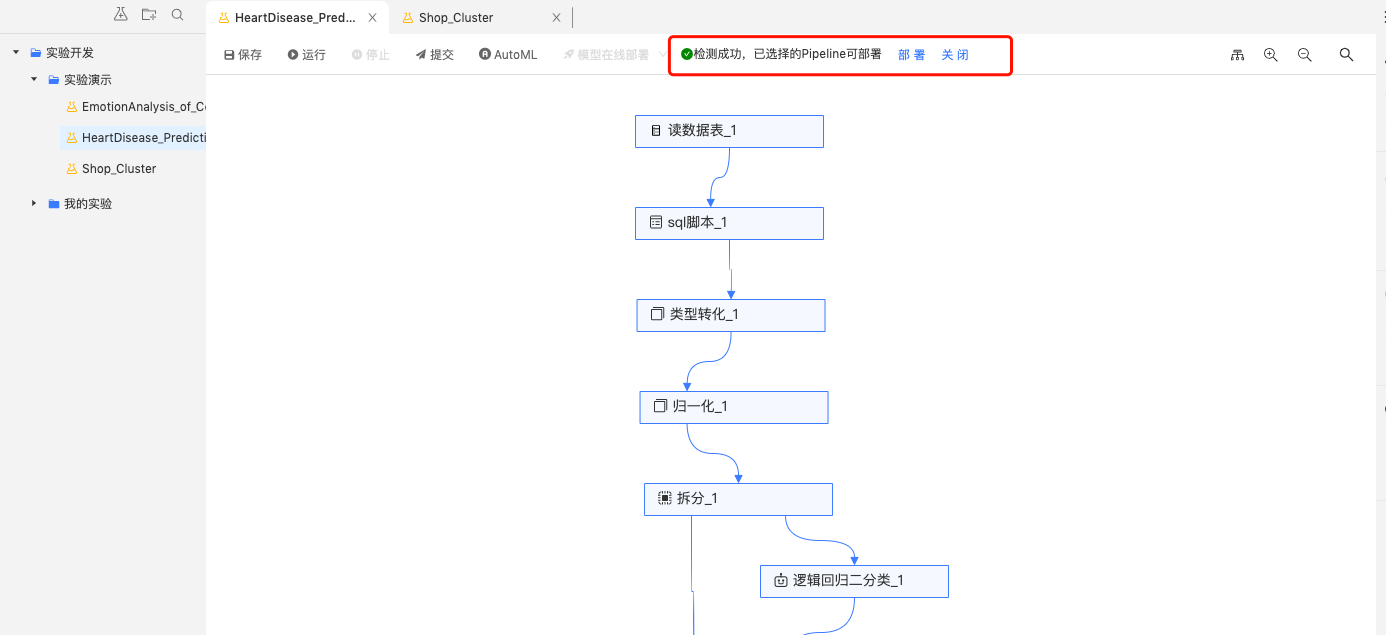

步骤二:选择实验画布中的机器学习模型,系统将自动检测出该模型所关联且可部署的Pipline,如下图。

-

可部署Pipline模型:Pipline目前包含数据源/目标、特征工程、机器学习、Python及拆分组件,且这些组件中间需连,不能包含其他类型组件,否则流程会断掉。

| AIWorks现支持的机器学习模型中,时间序列不支持模型在线部署。 |

-

Pipline检测状态:系统会自动检测除模型关联的Pipline,检测结果有以下几种:

| 检测状态 | 含义及操作 |

|---|---|

检测中 |

此时模型部署按钮置灰,该实验中的其他模型不可部署 |

检测成功 |

系统检测到可部署的Pipline,可开始“部署”或“关闭”,点击部署,继续部署流程;点击关闭,关闭检测到的Pipline,进行其他操作。 |

未检测到已选择内容的可部署Pipline |

系统未检测到,需按照可部署的Pipline组件规范检查实验流程。 |

步骤三:检测成功后,选择部署类型,定义模型名称与描述,后续流程与SingModel部署一致

-

选择部署模型:可选的模型为当前实验流程中运行成功的机器学习模型;

-

部署类型:包含新建模型服务与增加已有模型服务版本。

-

新建模型服务:即新增模型,需定义模型名称与模型描述。

-

模型名称:不超过32个字符,支持字母、数字与下划线;

-

模型描述:不超过200个字符,除空格外,不限制其他字符格式;

-

-

增加已有模型服务版本:选择已部署的某个模型,在该模型上增加一个版本号,同个模型的调用地址一样,可选择哪个版本对外提供服务。

-

选择已有模型:选择单个已部署模型;

-

模型版本号:系统自增,标识该模型;

-

-

步骤四:模型部署成功后,系统将提该模型的RestfulAPI,并可进入在模型管理页面进行模型调试,开始模型调用。